Récemment, le fondateur de Nvidia, Jensen Huang, dont la société construit les puces alimentant les systèmes d’intelligence artificielle les plus avancés d’aujourd’hui, fait: “Ce qui est vraiment très incroyable, c’est la façon dont vous programmez une IA, c’est comme la façon dont vous programmez une personne.” Ilya Sutskever, co-fondatrice d’Openai et l’une des principales figures de la révolution de l’IA, également déclaré que ce n’est qu’une question de temps avant que l’IA puisse faire tout ce que les humains peuvent faire, car «le cerveau est un ordinateur biologique».

Je suis un chercheur cognitif en neurosciences, et je pense qu’ils sont dangereusement faux.

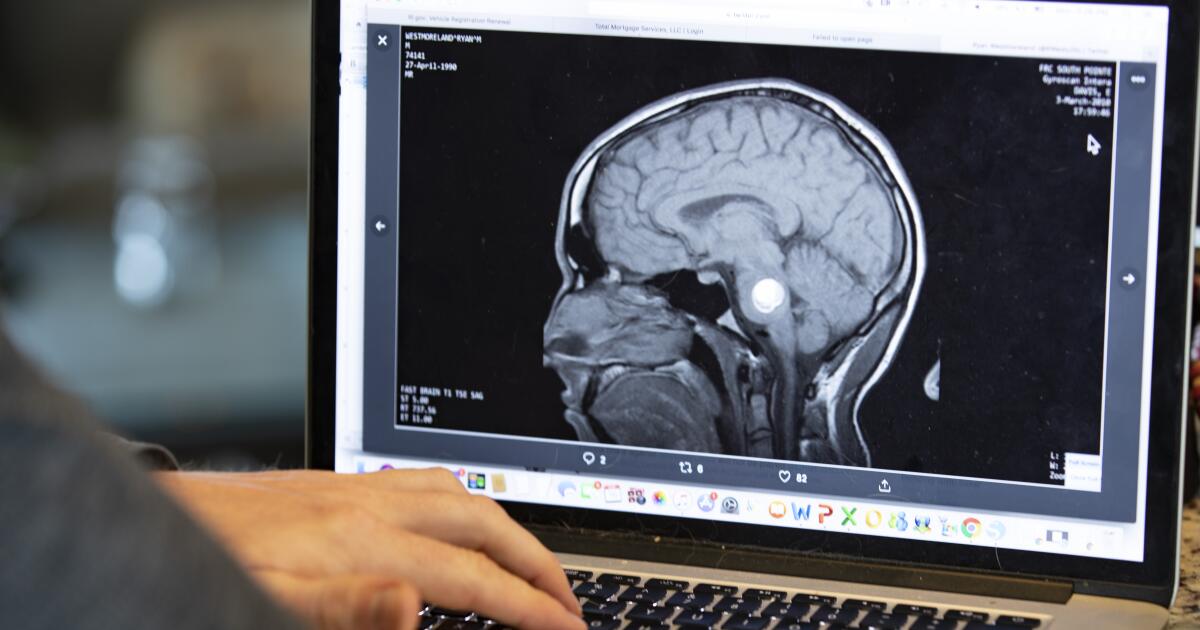

La plus grande menace n’est pas que ces métaphores nous confondent sur le fonctionnement de l’IA, mais qu’ils nous induisent en erreur au sujet de notre propre cerveau. Au cours des révolutions technologiques passées, les scientifiques, ainsi que la culture populaire, avaient tendance à explorer l’idée que le cerveau humain pourrait être compris comme analogue à une nouvelle machine après l’autre: une horloge, un standard, un ordinateur. La dernière métaphore erronée est que nos cerveaux sont comme des systèmes d’IA.

J’ai vu ce changement au cours des deux dernières années dans des conférences, des cours et des conversations dans le domaine des neurosciences et au-delà. Des mots comme «formation», «affinage fin» et «optimisation» sont fréquemment utilisés pour décrire le comportement humain. Mais nous ne nous entraînons pas, ne devons pas affiner ou optimiser comme le fait l’IA. Et de telles métaphores inexactes peuvent nuire réellement.

L’idée de l’esprit du XVIIe siècle comme une «ardoise vierge» imaginait les enfants comme des surfaces vides entièrement façonnées par des influences extérieures. Cela a conduit à des systèmes éducatifs rigides qui ont essayé d’éliminer les différences d’enfants neurodivergents, tels que ceux atteints d’autisme, de TDAH ou de dyslexie, plutôt que d’offrir un soutien personnalisé. De même, le modèle de «boîte noire» du début du XXe siècle de la psychologie comportementaliste affirmait que seul le comportement visible comptait. En conséquence, les soins de santé mentale se sont souvent concentrés sur la gestion des symptômes plutôt que sur la compréhension de leurs causes émotionnelles ou biologiques.

Et maintenant, il y a de nouvelles approches erronées émergentes alors que nous commençons à nous voir à l’image de l’IA. Outils éducatifs numériques développés dans Les dernières années, par exempleajuster les leçons et les questions en fonction des réponses d’un enfant, en gardant théoriquement l’élève à un niveau d’apprentissage optimal. Ceci est fortement inspiré par la formation d’un modèle d’IA.

Cette approche adaptative peut produire des résultats impressionnants, mais il néglige des facteurs moins mesurables tels que la motivation ou la passion. Imaginez deux enfants qui apprennent le piano à l’aide d’une application intelligente qui s’adapte à leur maîtrise changeante. On apprend rapidement à jouer parfaitement mais déteste chaque séance d’entraînement. L’autre fait des erreurs constantes mais profite de chaque minute. En jugeant uniquement les termes que nous appliquons aux modèles d’IA, nous dirons que l’enfant jouant parfaitement a surpassé l’autre étudiant.

Mais l’éducation des enfants est différente de la formation d’un algorithme d’IA. Cette évaluation simpliste ne expliquerait pas la misère du premier élève ou la jouissance du deuxième enfant. Ces facteurs comptent; Il y a de fortes chances que l’enfant s’amuse sera celui qui joue encore dans une décennie – et il pourrait même finir par un musicien meilleur et plus original parce qu’il aime l’activité, les erreurs et tout. Je pense vraiment que l’IA dans l’apprentissage est à la fois inévitable et potentiellement transformateur pour le mieux, mais si nous évaluerons les enfants uniquement en termes de ce qui peut être «formé» et «affiné», nous répéterons l’ancienne erreur de souligner la production plutôt que l’expérience.

Je vois cela se jouer avec des étudiants de premier cycle qui, pour la première fois, croient qu’ils peuvent atteindre les meilleurs résultats mesurés en externalisant pleinement le processus d’apprentissage. Beaucoup utilisent des outils d’IA au cours des deux dernières années (certains cours le permettent et certains ne le font pas) et comptent maintenant sur eux pour maximiser l’efficacité, souvent au détriment de la réflexion et de la véritable compréhension. Ils utilisent l’IA comme un outil qui les aide à produire de bons essais, mais le processus dans de nombreux cas n’a plus beaucoup de lien avec la pensée originale ou de découvrir ce qui suscite la curiosité des étudiants.

Si nous continuons à penser dans ce cadre du cerveau en tant que-AI, nous risquons également de perdre les processus de pensée vitaux qui ont conduit à des percées majeures en science et en art. Ces réalisations ne sont pas venues de l’identification des modèles familiers, mais de les briser par le désordre et les erreurs inattendues. Alexander Fleming a découvert la pénicilline en remarquant que des moisissures poussant dans une boîte de Pétri qu’il avait accidentellement laissée de côté tuait les bactéries environnantes. Une erreur chanceuse commise par un chercheur en désordre qui a continué à sauver la vie de centaines de millions de personnes.

Ce désordre n’est pas seulement important pour les scientifiques excentriques. Il est important pour chaque cerveau humain. L’une des découvertes les plus intéressantes en neurosciences au cours des deux dernières décennies est le «réseau de mode par défaut», un groupe de régions cérébrales qui devient active lorsque nous rêvons et ne nous sommes pas concentrés sur une tâche spécifique. Ce réseau s’est également avéré jouer un rôle en réfléchissant au passé, en imaginant et en pensant à nous-mêmes et aux autres. Le fait de ne pas tenir compte de ce comportement d’ardouillage de l’esprit comme un problème plutôt que de l’adopter en tant que caractéristique humaine de base nous amènera inévitablement à construire des systèmes imparfaits dans l’éducation, la santé mentale et le droit.

Malheureusement, il est particulièrement facile de confondre l’IA avec la pensée humaine. Microsoft décrit des modèles d’IA génératifs comme Chatgpt sur son site officiel En tant qu’outils qui «reflètent l’expression humaine, redéfinissant notre relation avec la technologie». Et le PDG d’Openai, Sam Altman, a récemment mis en évidence sa nouvelle fonctionnalité préférée de Chatgpt intitulée «Memory». Cette fonction permet au système de conserver et de rappeler les détails personnels entre les conversations. Par exemple, si vous demandez à Chatgpt où manger, cela pourrait vous rappeler un restaurant thaïlandais que vous avez mentionné vouloir essayer des mois plus tôt. «Ce n’est pas que vous vous branchiez votre cerveau en une journée», a déclaré Altman expliqué“Mais … ça apprendra à vous connaître, et cela deviendra cette extension de vous-même.”

La suggestion selon laquelle la «mémoire» de l’IA sera une extension de la nôtre est à nouveau une métaphore erronée – nous conduisant à mal comprendre la nouvelle technologie et notre propre esprit. Contrairement à la mémoire humaine, qui a évolué pour oublier, mettre à jour et remodeler les souvenirs basés sur une myriade de facteurs, la mémoire d’IA peut être conçue pour stocker des informations avec beaucoup moins de distorsion ou d’oubli. Une vie dans laquelle les gens externalisent la mémoire à un système qui se souvient presque de tout n’est pas une extension de soi; Il se détache des mécanismes mêmes qui nous rendent humains. Cela marquerait un changement dans la façon dont nous nous comportons, comprendrons le monde et prendrait des décisions. Cela pourrait commencer par de petites choses, comme le choix d’un restaurant, mais cela peut rapidement passer à des décisions beaucoup plus importantes, comme prendre un cheminement de carrière différent ou choisir un partenaire différent de ce que nous aurions, car les modèles d’IA peuvent faire surface les connexions et le contexte que notre cerveau peut avoir éliminé pour une raison ou une autre.

Cette externalisation peut être tentante parce que cette technologie nous semble humaine, mais l’IA apprend, comprend et voit le monde de manière fondamentalement différente et ne ressent pas vraiment de la douleur, de l’amour ou de la curiosité comme nous. Les conséquences de cette confusion continue pourraient être désastreuses – non pas parce que l’IA est intrinsèquement nocive, mais parce que au lieu de la transformer en un outil qui complète notre esprit humain, nous lui permettons de nous remodeler à sa propre image.

À lui inférieur GEF et pHD candidat en neurosciences cognitives de l’Université de Columbia et auteur du roman «L’usine de cloud de Mme Lilienblum. ». Sa newsletter subs-dos, Histoires de neuronesrelie les idées des neurosciences au comportement humain.